#11 Advanced: Wie skaliere ich Prompts für Education?

Worum geht es in diesem Artikel?

Mit Microsoft Promps for Education & Language Models werden Schulungsunterlagen automatisiert erstellt. Deep Learning als Beispiel. Fokus: Systemanpassung, effektive Übungen & Themenstrukturierung. #AutomatisierteSchulungsunterlagen #DeepLearning #MicrosoftPromps.

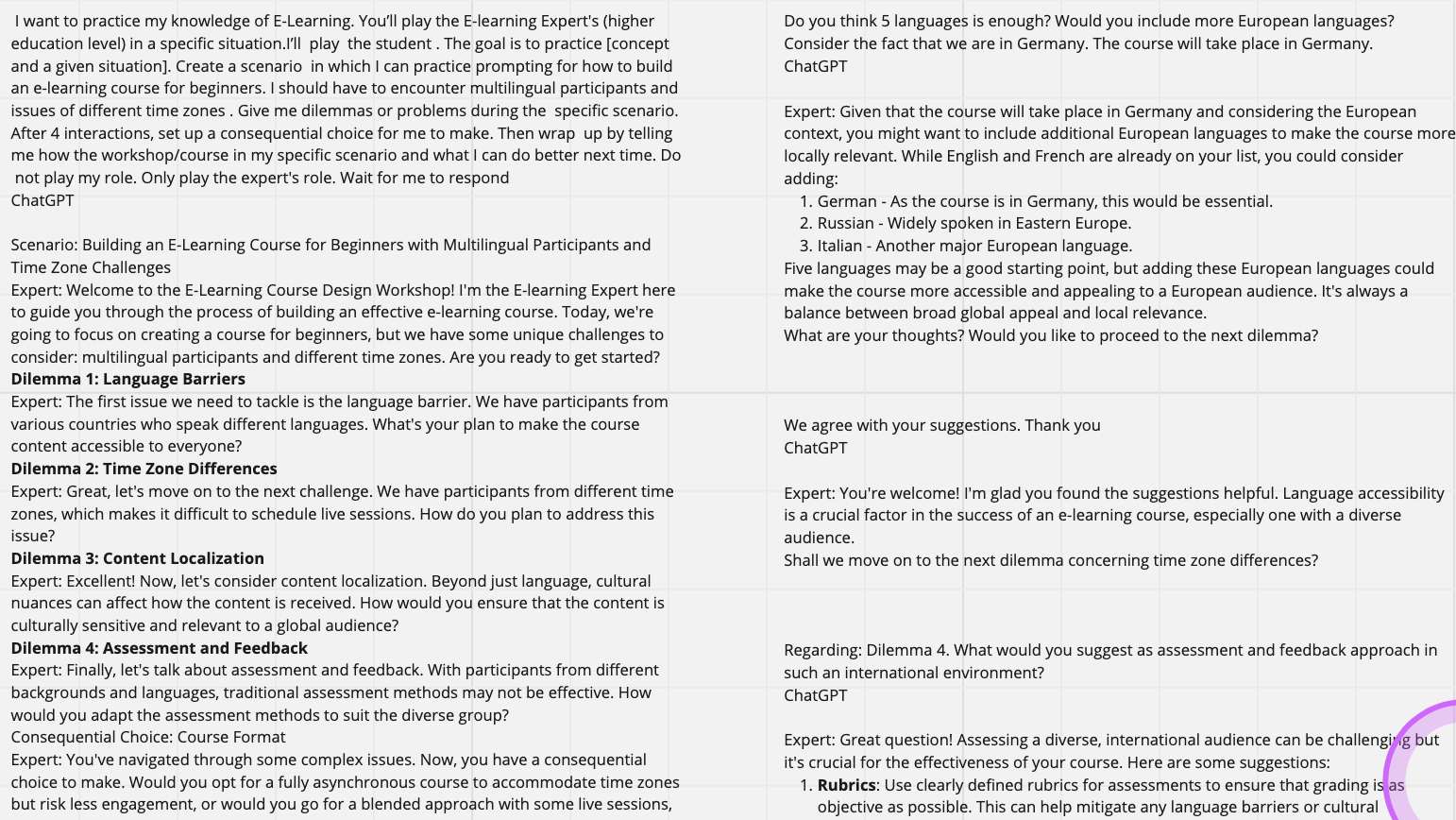

Wie nutze ich KI Lösungen für die Erstellung von Schulungsunterlagen, in der Schulung, zur Vorbereitung? KI-Systeme und Lösungen helfen uns aus verschiedenen Perspektiven einfacher, schneller und besser zu lernen.

Das Dokument beschreibt zwei Events (Überblick Microsoft Prompts for Edu und Skalierung der Prompts) die wir bei KI-Insights in den letzten zwei Wochen durchgeführt haben. Weiter unten im Dokument befindet sich eine Beschreibung der wichtigsten Steps und ein beschreibendes Video.

Auslöser war das ich auf github die Microsoft Prompts for Education gefunden habe. Microsoft hat verschiedene Prompts „gebaut“ die für Educators, Staff, Students und Administration eine Erleichterung bringen sollen.

Als Grundlage der Microsoft Prompts ist dieses Dokument aufgeführt:

Nach dem ersten Workshop habe ich folgende Präsentation erstellt die nicht direkt auf die Prompts eingegangen ist, sondern wie man mit KI Lösungen schnell Präsentationen erstellt.

Hier ein Video des Workflows

Was waren die Inhalte der Events im Detail?

Event 1

Im ersten Event haben wir in Arbeitsgruppen die Microsoft Prompts for Edu aus verschiedenen Blickwinkel diskutiert.

Das Ergebnis war, das es sich lohnen würde die Prompts in eine Skalierung zu übertragen. Damit war der zweite Event geboren.

Event 2

Quellen

Die Prompts die wir untersucht haben beziehen sich auf drei Publikationen:

- Microsoft Prompts for Education

- Utilizing ChatGPT & Prompt Engineering von LearnWorlds

Das ist ein interessantes Dokument, das ganz viele Prompts zeigt die für Educations wichtig sind. - Assigning AI: Seven Approaches for Students, with

Prompts

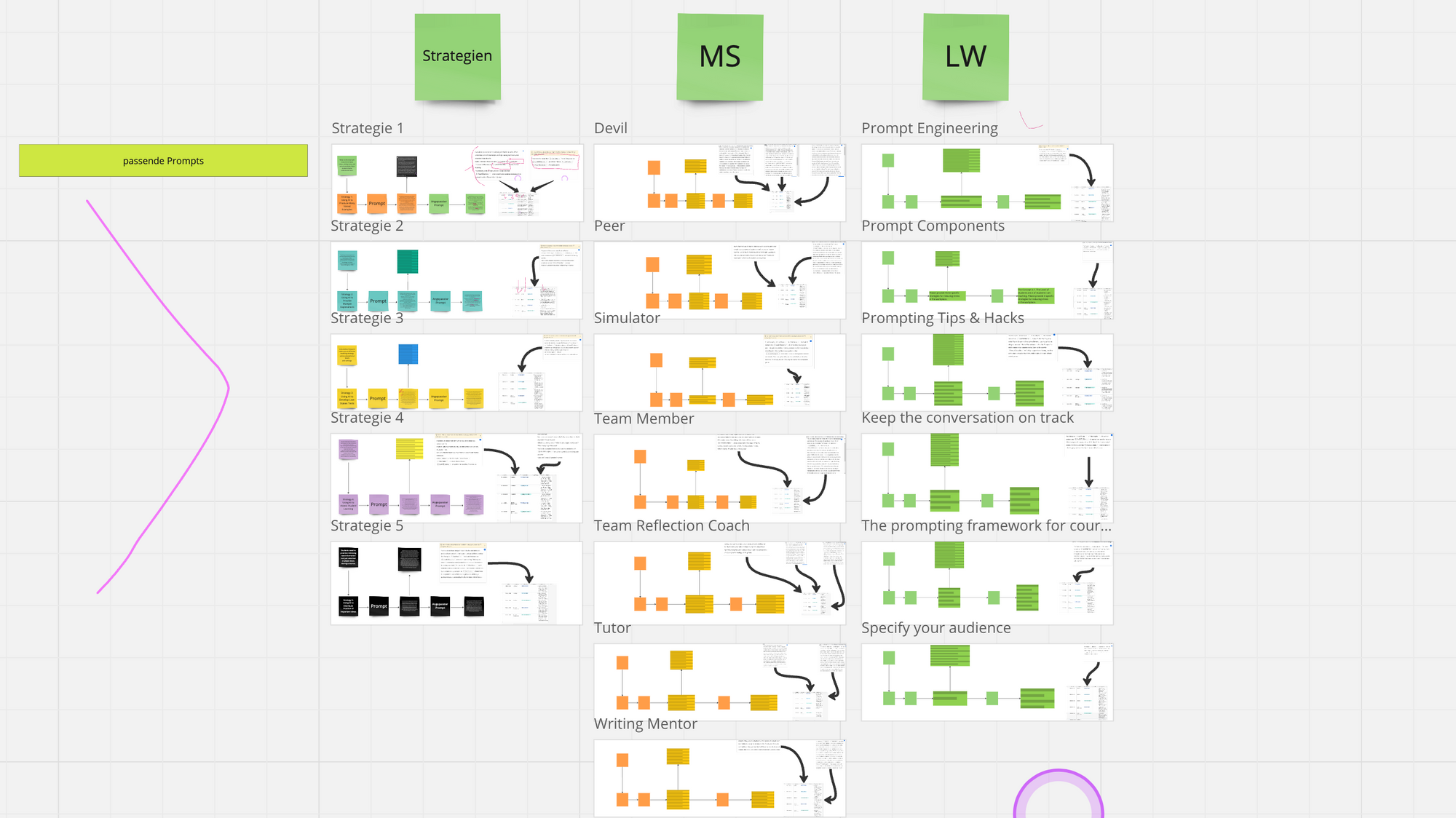

Übersicht über das Miroboard und Testen der Prompts

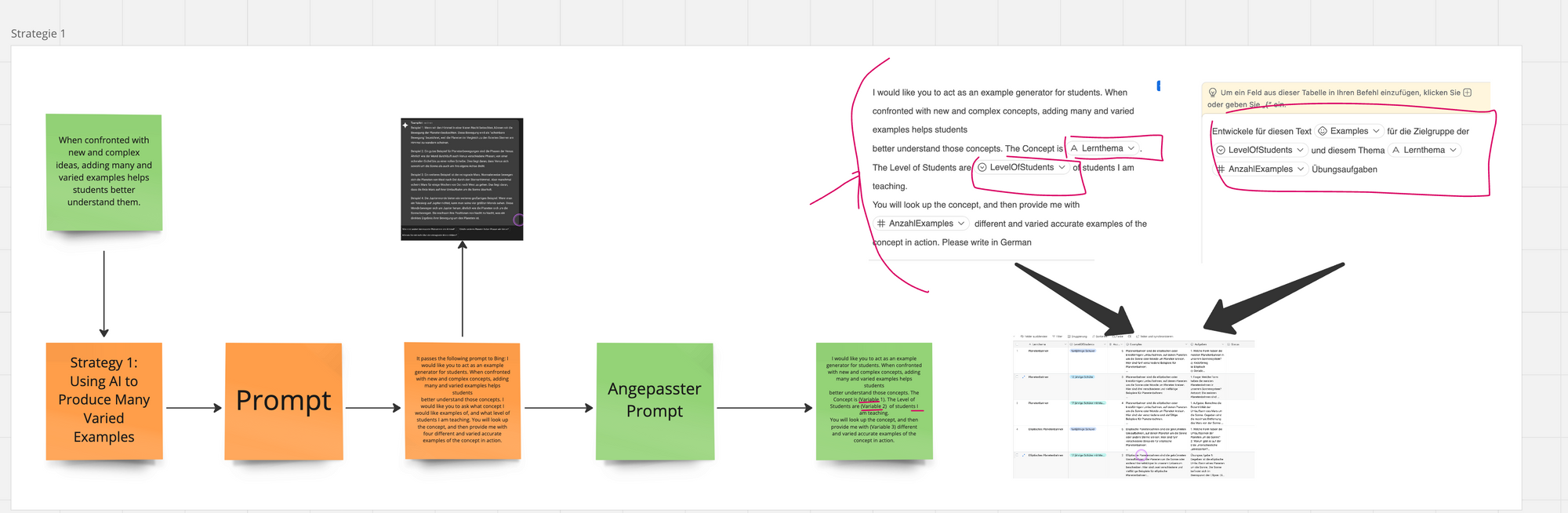

Wir haben über 20 Prompts aus diesen beiden Beispielen ausprobiert und an eine Variablensteuerung angepasst.

Beispiel eines Prompts mit Anpassung für die Skalierung

Airtable mit KI Funktionalität

Airtable hat in der Beta eine KI-Funktion und kann aus den Inhalten der Spalten KI-Antworten generieren. Siehe auf dem Bild KI-Funktionen in Airtable. Das ist sehr spannend, denn jetzt kann man schnell KI-Funktionen in seine Tabellen einbauen. In Zukunft wird sicher auch Midjourney oder Dall-E integriert werden.

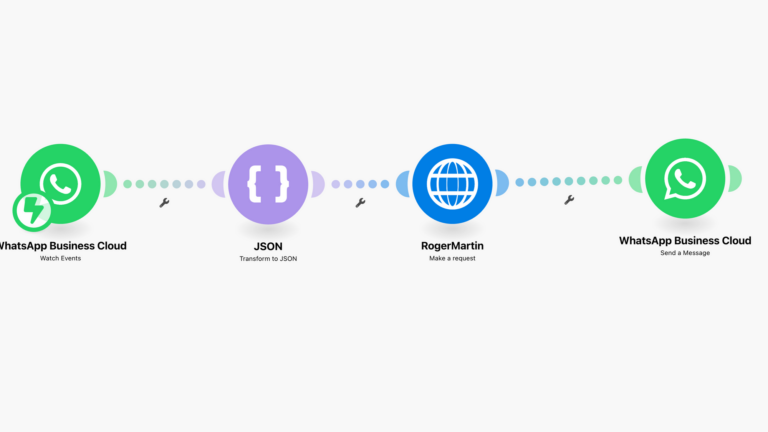

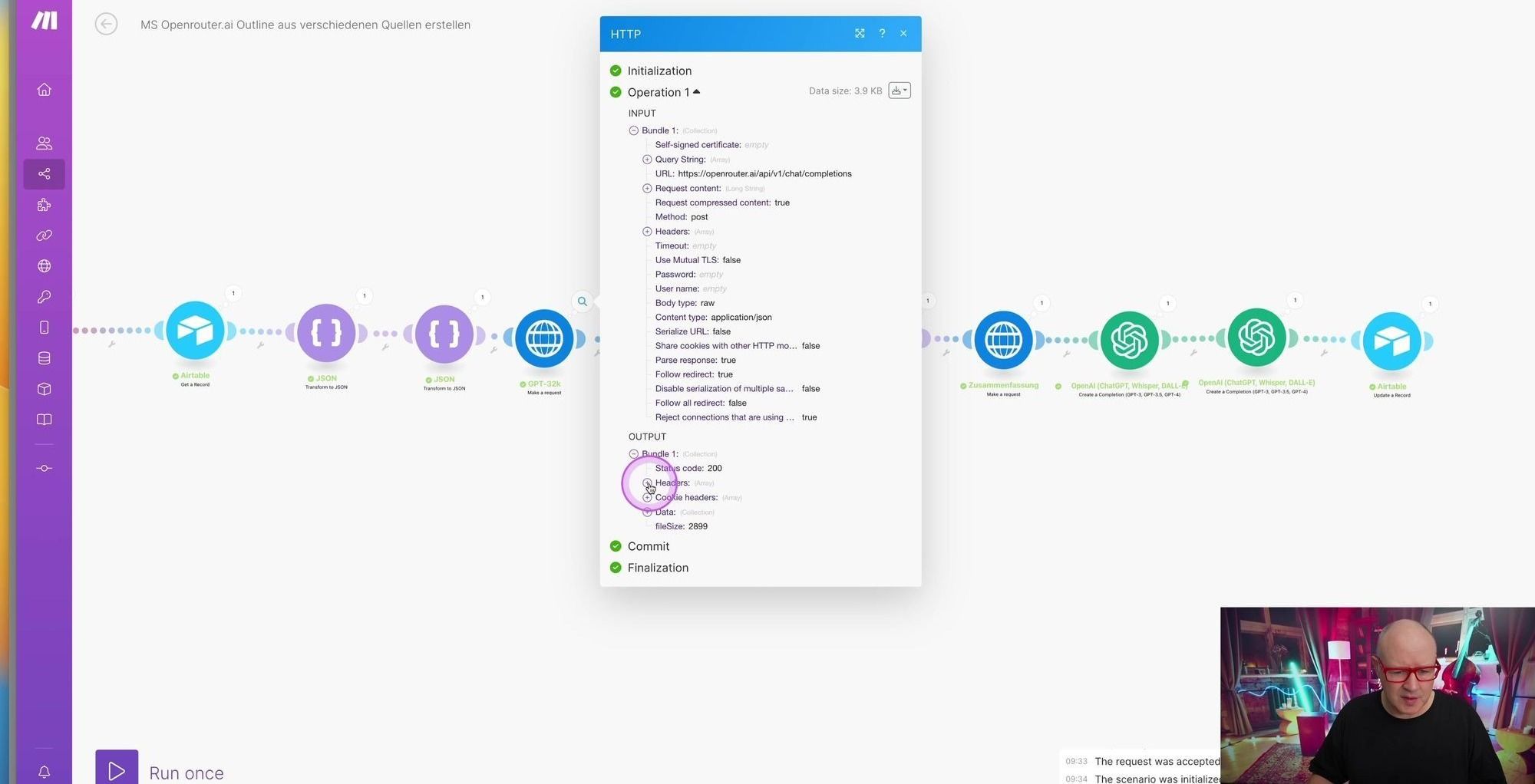

Ist die Airtable KI gut genug für meine Zwecke? Deshalb baue ich eine Automatisierung um die Airtable KI zu überprüfen.

Wie kann ich die Airtable KI Überprüfen?

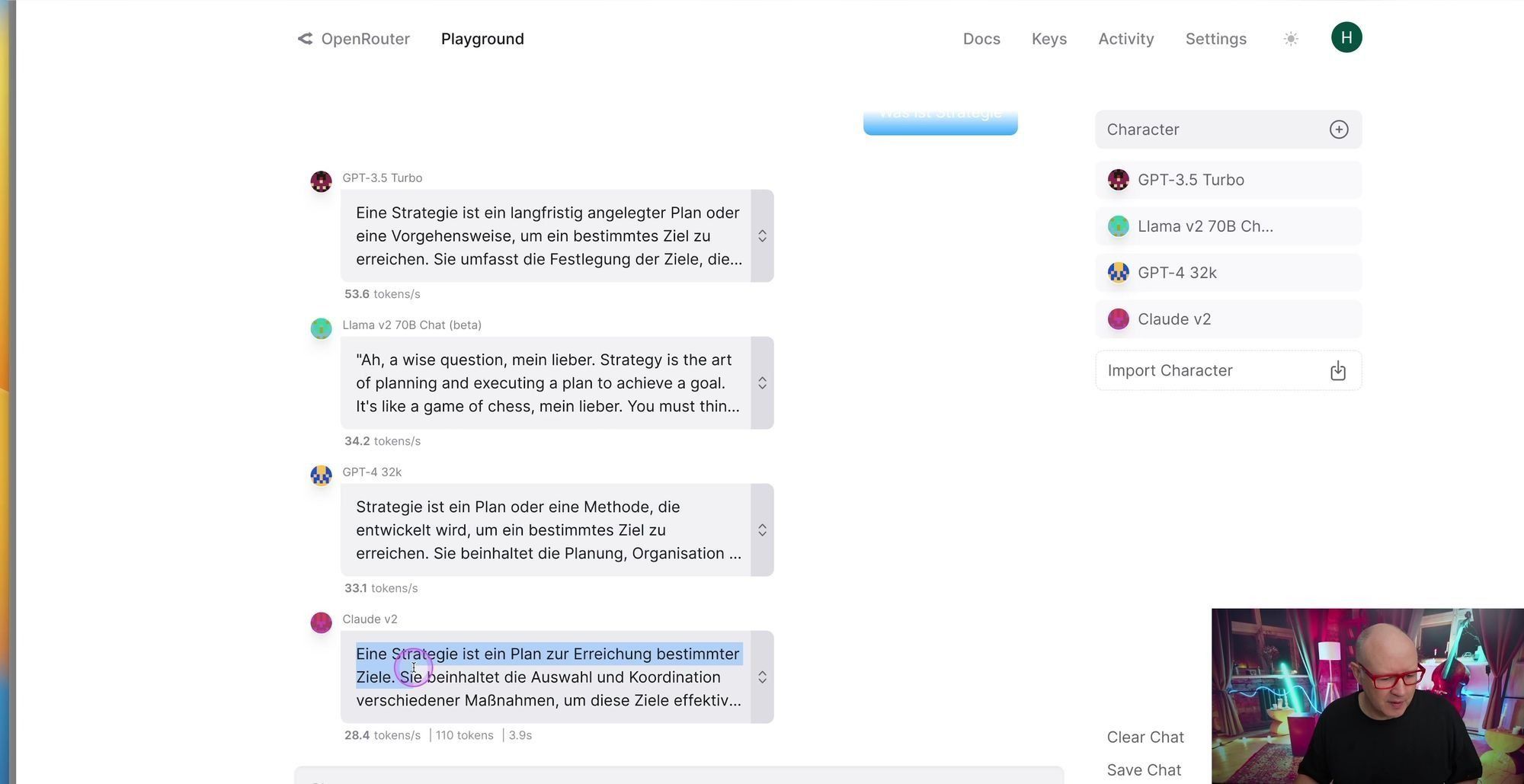

Ich frage durch einen Post-Request verschiedene LLMs über OpenRouter.ai ab. OpenRouter ist eine Plattform die verschiedene LLMs bereitstellt, die man über einen Post-Request abfragen kann. Die einzelnen Schritte sind im Video tiefer erklärt. Mit OpenRouter kann ich auch schnell über die GUI LLMs vergleichen.

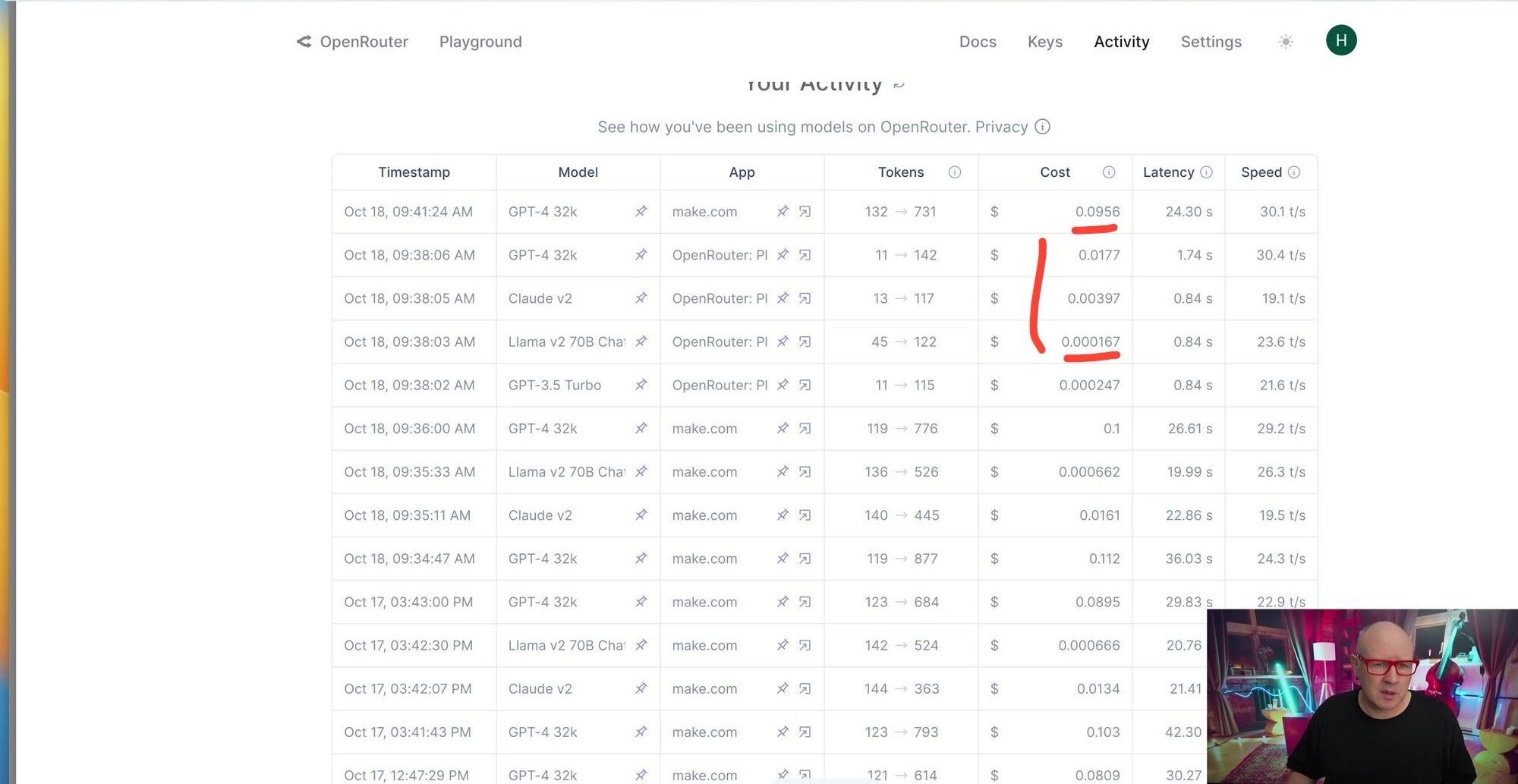

Die Preise im Blick

LLamaV2 kostest ungefähr 1 % Prozent des Preises von GPT32K. Deshalb macht es auch Sinn LLamaV2 stetig zu testen.

Das Ergebnis

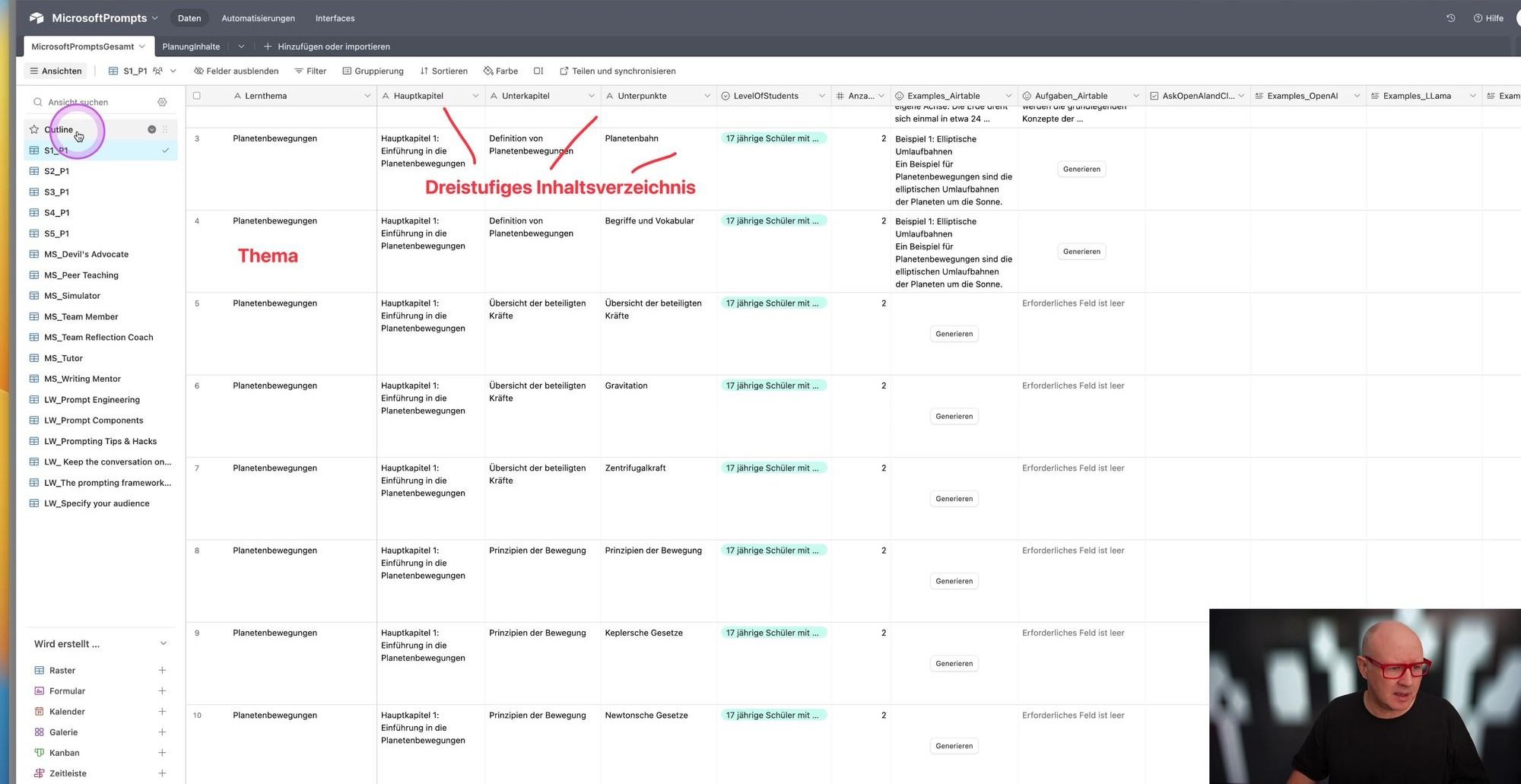

Ein Outline, das in einer dreistufigen Gliederung vorliegt

Wie komme ich von dem Outline in die dreistufige Gliederung?

Das Ziel ist es, jede Zeile des Outlines in eine neue Zeile in einer anderen Tabelle einzutragen und die Zeile zu splitten nach dem Vorbild unten.

Wie kann ich Text des Outlines strukturieren?

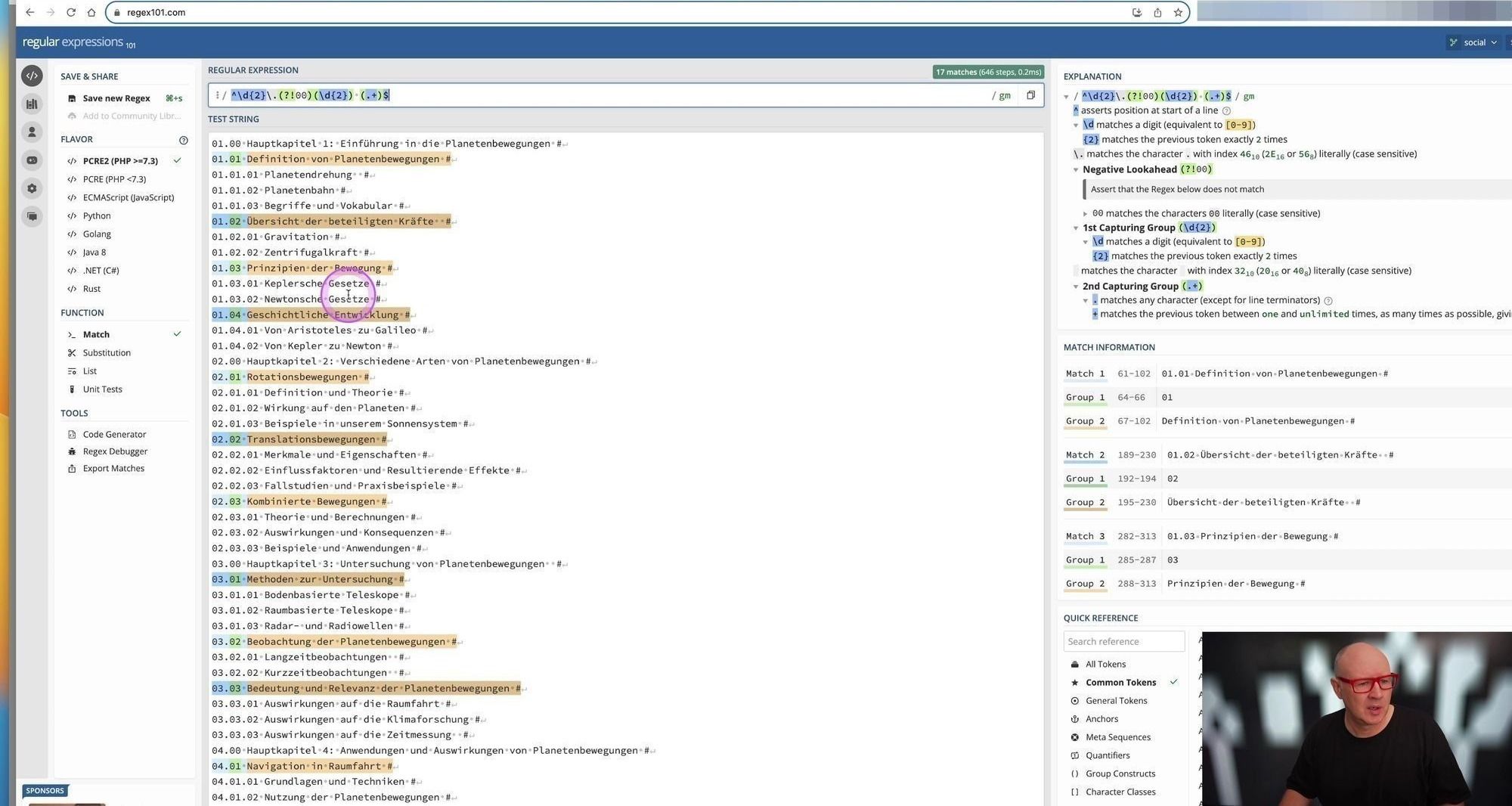

Das Ergebnis der Outline-Erstellung hat folgende dreistufige Struktur

01.00 Einführung in die Candidate Journey # – Erste Ebene

01.01 Definition und erklärende Übersicht # – Zweite Ebene

01.01.01 Was ist die Candidate Journey? # – Dritte Ebene

01.01.02 Der Vergleich zur Customer Journey #

01.01.03 Wichtigkeit der Candidate Journey #

01.02 Stakeholder der Candidate Journey #

01.02.01 Kandidaten #

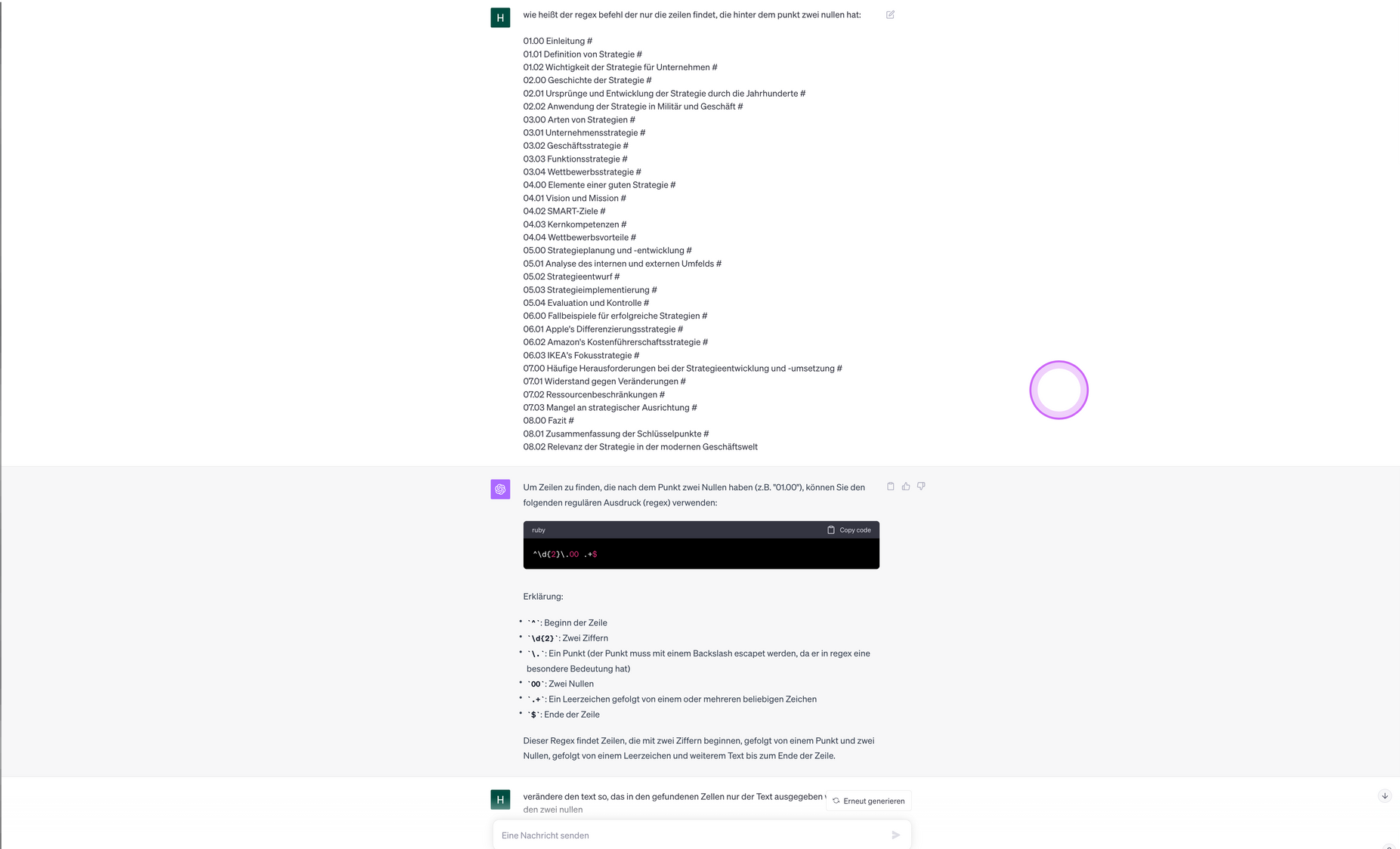

Ich brauche ein Skript das mir das Outline nimmt und jedes Element in eine neue Zeile bringt und den Text aufteilt in Hautkapitel, Unterkapitel und Unterpunkte. Hier zeige ich kurz (unvollständig) das Skript und wie man RegEx dafür nutzt. Diese Struktur war mein erster Versuch und kann man auch eleganter machen.

Ich könnte das Outline auch in einem Google Doc schreiben und dann mit Make.com jede Zeile (Absatz) aufsplitten und bearbeiten. Dann hätte ich nicht die dreistufige Gliederung.

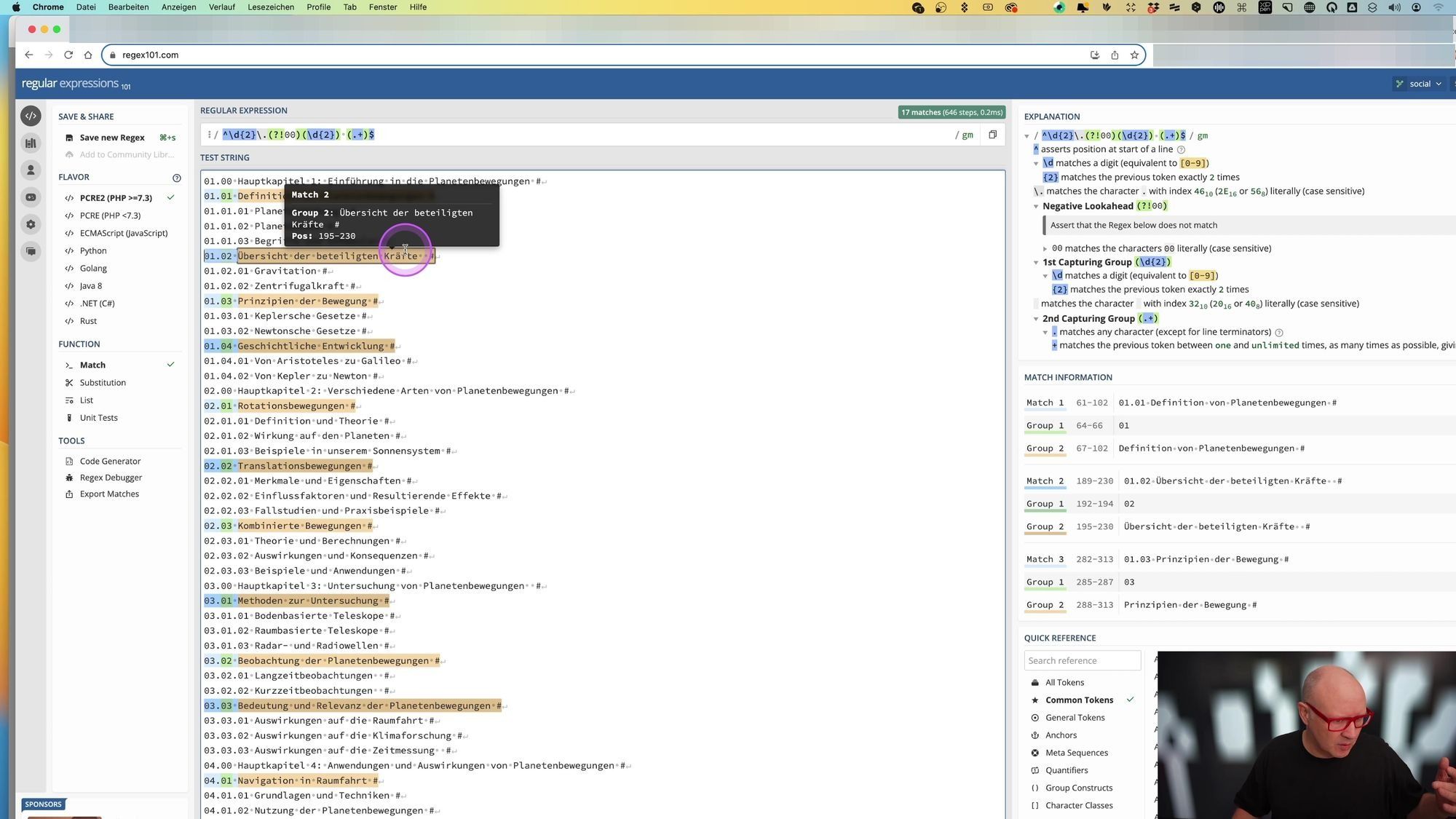

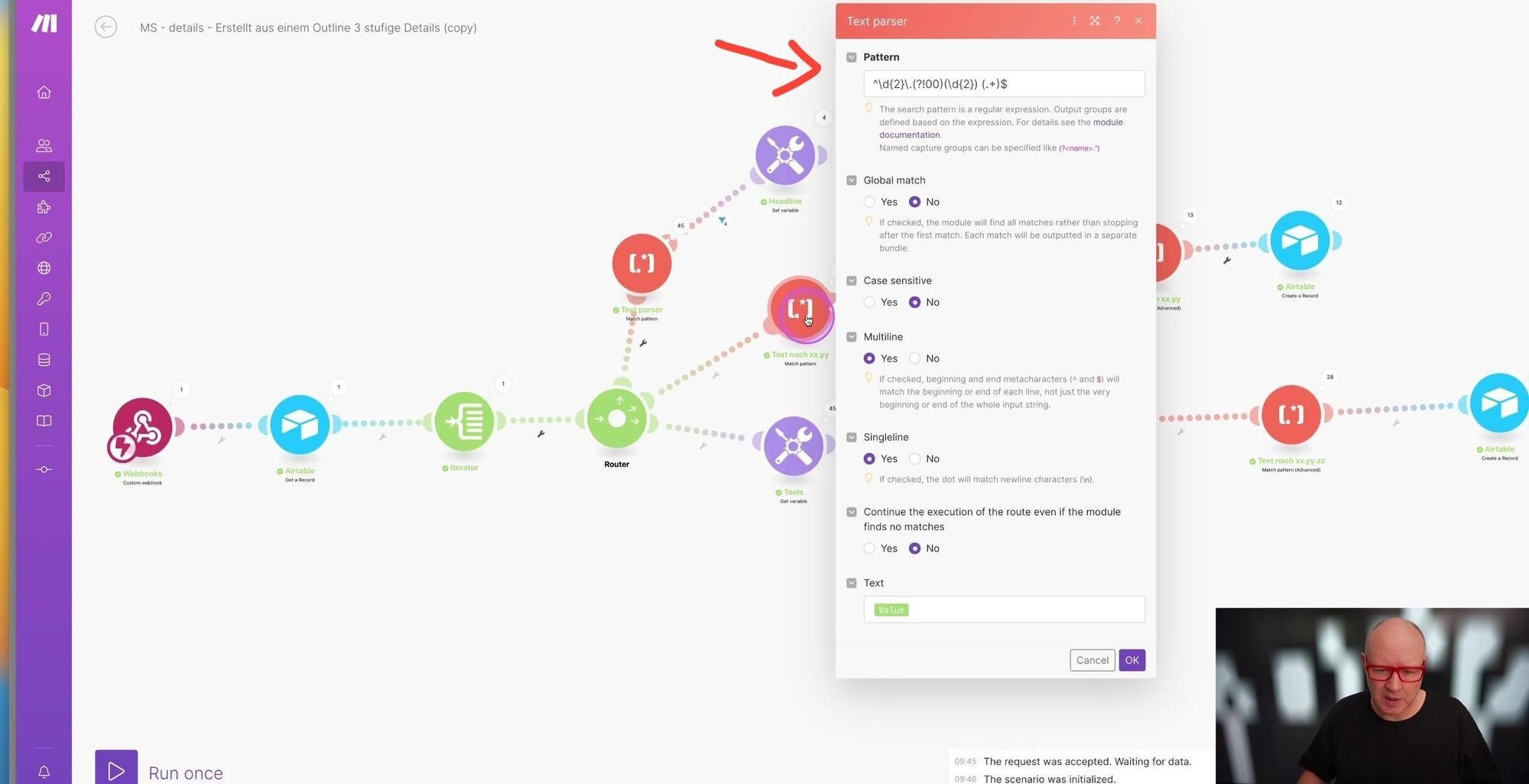

RegEx Skript

Diese Skript, teilt jede Zeile auf und trägt diese in einen neue Tabelle ein.

Kernbestandteile sind RegEx Befehle die mir einen Text nach Mustern (Pattern) durchsuchen.

regex101

Dazu habe ich den Text in das Programm regex101.com kopiert und dann verschiedene Regex Befehle getestet die mir die Nummern und den Text splitten.

Regex mit ChatGPT

Die Regex Befehle kann man sich wunderbar mit ChatGPT entwickeln lassen. Früher habe ich ausprobiert und ausprobiert.

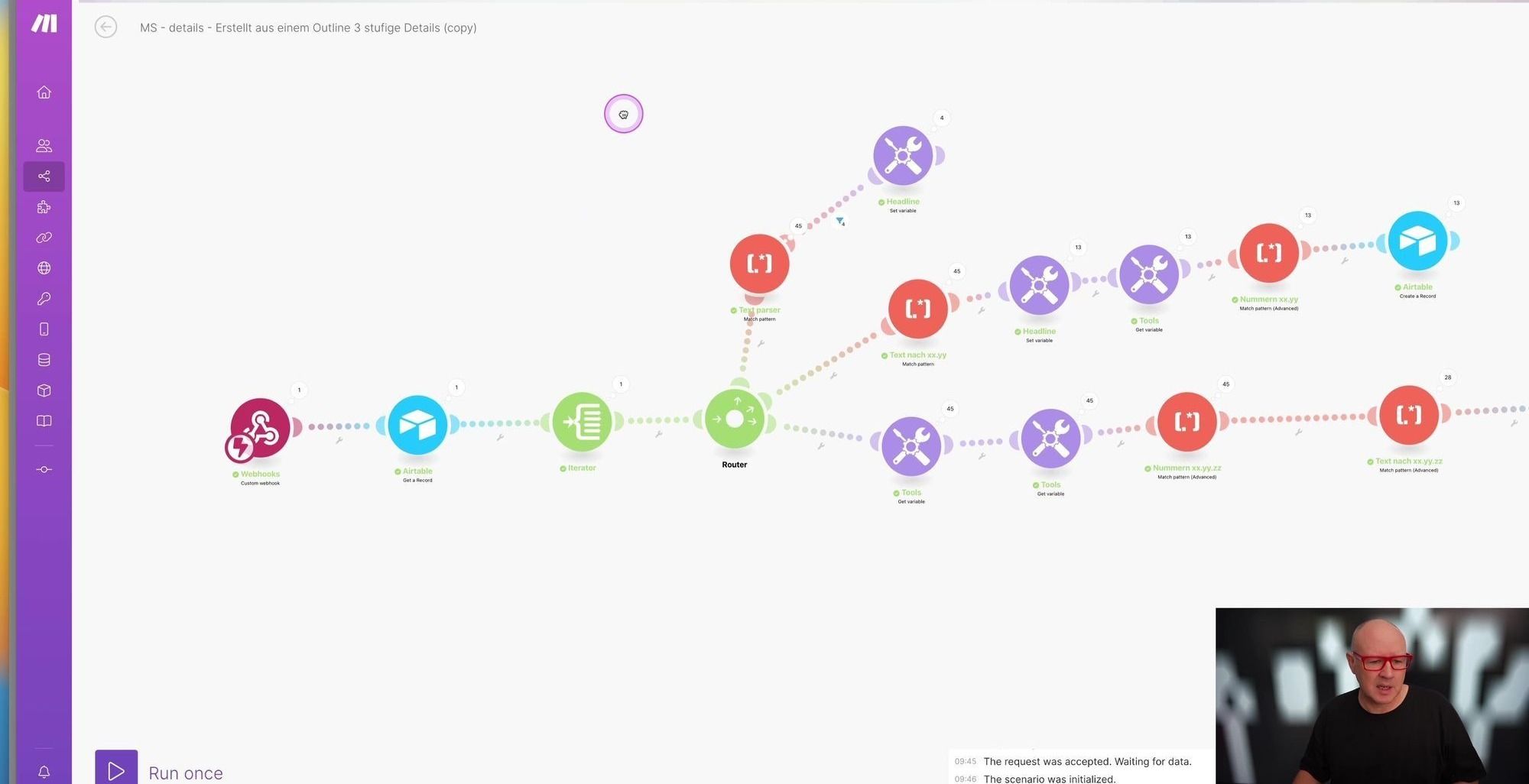

Wie kann ich den Inhalt der KI Antworten überprüfen?

Hierzu habe ich wieder ein Make-Skript gemacht, das mit der KI (GPT-32k) die Antworten überprüft. Nachdem sich einige LLMs etabliert haben oder ich ein „finegetunetes“ Modell auf meine Bedürfnisse haben, wird der Aufwand des „gegencheckens“ mit der Zeit immer weniger werden.

Zusammenfassung Was fehlt?

Zusammenfassend kann ich ein automatisches Outline erstellen, dieses überprüfen und dann die Prompts aus dem Edu-Bereich ausprobieren.

Was noch fehlt ist eine logische Struktur die die Prompts in eine Reihenfolge bringt und eine automatische Dokumenterstellung.

Das wird eines der nächsten Events sein.