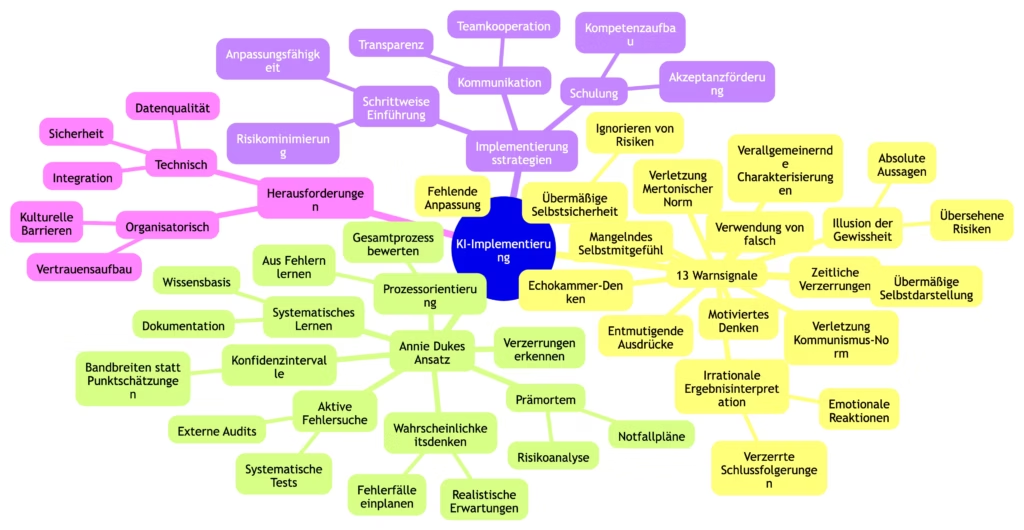

#170 KI-Implementierung 13 Warnsignale

Worum geht es in diesem Artikel?

Der Text zeigt 13 Warnsignale bei denen Sie vielleicht gehen sollten, falls ein KI-Experte solche Wörter von sich gibt.

KI-Implementierung: Warnsignale und erfolgreiche Strategien

Die Implementierung von künstlicher Intelligenz (KI) birgt zahlreiche Herausforderungen und Risiken. Es ist wichtig, die Warnsignale zu kennen und zu verstehen, um negative Folgen zu vermeiden.

Hintergrund dieses Blog Posts, bei dem ich endlich mal auf Annie Duke tiefer eingehe, war ein Post eines jungen wilden KI-Kollegen der einen Ansatz einer Versicherung als „Quatsch, in die Irre, Schuss nicht gehört“ bezeichnet hatte. Dabei sind bei mir alle Alarmglocken angegangen, weil ich Annie Dukes Buch „THINKING IN BETS: MAKING SMARTER DECISIONS WHEN YOU DON’T HAVE ALL THE FACTS“ noch in Erinnerung hatte. Der Blogpost zeigt 13 kritische Warnsignale auf die sie achten sollten bei der Einstellung von KI-Experten. Ich habe Annie Dukes Beispiele auf den Kontext angepasst.

Das Wichtigste auf einen Blick

- Das Erkennen von irrationalem Denken ist entscheidend für die erfolgreiche Implementierung von KI-Systemen

- Wichtige Warnsignale wie übermäßige Selbstsicherheit und mangelnde Transparenz müssen beachtet werden

- Schulungsprogramme und effektive Kommunikation sind unerlässlich für die Akzeptanz und Nutzung von KI-Technologien

- In einer Welt wo wir niemals alle Daten haben werden, beschreibt Annie Duke einen Weg mit unvollständigen Daten umzugehen

Einführung

In einer Zeit, in der die Grenzen zwischen menschlicher und künstlicher Intelligenz zunehmend verschwimmen, ist es entscheidend, irrationales Denken zu erkennen und zu vermeiden. Inspiriert von Annie Dukes “Thinking in Bets” bietet dieser Beitrag eine detaillierte Analyse der von Duke identifizierten Warnsignale, erweitert um spezifische Beispiele aus dem Bereich der künstlichen Intelligenz. Duke, eine ehemalige Poker-Weltmeisterin und Entscheidungsstrategin, hat durch ihre Erfahrungen im Poker gelernt, unter Druck und mit unvollständigen Informationen die bestmöglichen Entscheidungen zu treffen. Diese Erkenntnisse sind besonders wertvoll für die heutige Zeit, in der wir uns immer mehr auf KI verlassen.

Die Fähigkeit, Entscheidungen unter Unsicherheit zu treffen, ist nicht nur im Poker, sondern auch in der Geschäftswelt und im täglichen Leben von entscheidender Bedeutung. Durch die Kombination aus praktischer Erfahrung und theoretischer Analyse bietet Duke wertvolle Einblicke, wie wir in einer zunehmend von KI geprägten Welt rationalere Entscheidungen treffen können.

Was folgt, ist eine detaillierte Analyse der Warnsignale bei der KI-Implementierung, um uns zu helfen, diese Herausforderungen besser zu meistern.

13 kritische Warnsignale bei der KI-Implementierung

1. Illusion der Gewissheit

Die Illusion der Gewissheit kann ebenfalls ein erhebliches Warnsignal bei der KI-Implementierung sein. Diese Illusion äußert sich in Aussagen wie “Ich weiß” oder “Ich bin mir sicher” und kann zu einer verzerrten Wahrnehmung der Realität führen. Im Kontext der künstlichen Intelligenz zeigt sich diese Illusion oft in Aussagen wie “KI wird definitiv alle Jobs ersetzen” oder “Diese KI ist absolut fehlerfrei”.

Solche absoluten Aussagen können dazu führen, dass Risiken und Unsicherheiten übersehen werden. Die Realität ist jedoch, dass KI-Systeme Fehler machen können und ihre Leistungsfähigkeit nicht immer garantiert ist. Ein kritischer und realistischer Blick auf die Möglichkeiten und Grenzen der KI ist daher entscheidend, um Missverständnisse und Fehlentscheidungen zu vermeiden.

Originale Beispiele:

Beispiele für die Illusion der Gewissheit sind Aussagen wie “Ich weiß” oder “Ich bin mir sicher”. Solche absoluten Begriffe wie “beste” oder “schlechteste” können ebenfalls die Wahrnehmung verzerren und zu falschen Annahmen führen.

Beispiele im KI-Kontext:

- „KI wird definitiv alle Jobs ersetzen“

- „Diese KI ist absolut fehlerfrei“

- „Ich weiß genau, wie KI funktioniert“

2. Übermäßige Selbstsicherheit und Überheblichkeit

Übermäßige Selbstsicherheit kann bei der Implementierung von KI-Systemen zu gravierenden Fehlern führen. Ein übertriebenes Vertrauen in die eigenen Fähigkeiten kann dazu führen, dass notwendige Anpassungen ignoriert werden. Wenn Entscheidungsträger glauben, sie wüssten alles über die Implementierung von KI, werden kritische Risiken oft vernachlässigt. Dies kann schwerwiegende Konsequenzen haben, besonders wenn Probleme auftreten, die nicht vorhergesehen wurden.

Eine übermäßige Selbstsicherheit kann auch dazu führen, dass Fehler und Schwachstellen in den KI-Systemen übersehen werden. Dies zeigt sich oft in der selektiven Berichterstattung über KI-Leistungen und dem Verschweigen von KI-Fehlern. Ein realistischer Ansatz zur Bewertung der eigenen Fähigkeiten und der potenziellen Risiken ist daher unerlässlich, um eine erfolgreiche Implementierung zu gewährleisten.

Originale Beispiele:

Beispiele für Überheblichkeit sind ähnliche Ausdrücke wie bei der Gewissheitsillusion, wie “Ich weiß” oder “Ich bin mir sicher”. Übertriebene Selbstsicherheit und emotionale Reaktionen auf die Leistungsfähigkeit von KI sind weitere Anzeichen.

Beispiele im KI-Kontext:

- „Ich verstehe KI-Systeme perfekt“

- „Meine KI-Implementierung ist fehlerlos“

- Ignorieren von Risiken und Herausforderungen

3. Irrationale Ergebnisinterpretation

Die irrationale Interpretation von KI-Ergebnissen kann die Effizienz und Sicherheit der Entscheidungen erheblich beeinträchtigen. Emotionale Faktoren und Vorurteile können zu verzerrten Schlussfolgerungen führen.

Originale Beispiele:

Beispiele für irrationale Ergebnisinterpretation sind Aussagen wie “Ich kann nicht fassen, wie viel Pech ich hatte” oder “Ich bin in absoluter Höchstform”.

Solche Aussagen zeigen, wie emotionale Reaktionen die Objektivität beeinträchtigen und zu verzerrten Schlussfolgerungen führen können.

Beispiele im KI-Kontext:

- „Die KI funktioniert nur bei mir nicht“

- „Unser Konkurrent hatte einfach Glück mit seinem KI-Modell“

- Selektive Wahrnehmung von Erfolgen und Misserfolgen

4. Verallgemeinernde Charakterisierungen

Verallgemeinernde Charakterisierungen können zu Missverständnissen führen und die Wahrnehmung der KI-Technologie verzerren. Solche Generalisierungen vereinfachen die Komplexität der Technologie zu stark.

Originale Beispiele:

Beispiele für verallgemeinernde Charakterisierungen sind Aussagen wie “Wieder so ein typischer __“ oder die Verwendung von abwertenden Begriffen wie “Idiot” oder “Esel”. Solche Pauschalurteile können die Wahrnehmung der Technologie stark verzerren und zu Missverständnissen führen.

Beispiele im KI-Kontext:

- „Typischer KI-Skeptiker“

- „Noch so ein Tech-Utopist“

- Pauschale Urteile über KI-Technologien

5. Verletzung der Mertonischen Norm des Universalismus

Die Akzeptanz oder Ablehnung von KI-bezogenen Informationen sollte nicht vom Absender abhängen. Die Mertonische Norm besagt, dass wissenschaftliche Erkenntnisse unabhängig von ihrer Herkunft bewertet werden sollten.

Originale Beispiele:

Beispiele für die Verletzung der Norm des Universalismus sind Begriffe wie “Waffennarr” oder “Gutmensch”, die die Akzeptanz einer Nachricht stark beeinflussen können. Solche Aussagen zeigen, wie Vorurteile die Wahrnehmung und Bewertung von Informationen verzerren können.

Beispiele im KI-Kontext:

- Vorurteile gegenüber bestimmten KI-Entwicklern oder -Unternehmen

- Ablehnung von KI-Lösungen aufgrund ihrer geografischen Herkunft

- Bevorzugung bestimmter KI-Anbieter ohne sachliche Grundlage

6. Zeitliche Verzerrungen

Zeitliche Verzerrungen beeinflussen die Wahrnehmung von KI-Ereignissen und deren Bedeutung über die Zeit. Diese können zu einer verzerrten Bewertung von KI-Implementierungen führen.

Originale Beispiele:

Beispiele für zeitliche Verzerrungen sind Aussagen wie “Schlimmster Tag aller Zeiten” oder “Ein Tag aus der Hölle”. Solche Aussagen zeigen, wie einzelne negative Ereignisse die Wahrnehmung eines gesamten Zeitraums verzerren können.

Beispiele im KI-Kontext:

- „Seit KI ist alles schlechter geworden“

- „Dieser eine KI-Fehler hat alles ruiniert“

- Überbewertung einzelner negativer Erfahrungen

7. Motiviertes Denken

Motiviertes Denken beeinflusst die Informationsverarbeitung und Entscheidungsfindung bei KI-Implementierungen durch emotionale und persönliche Vorlieben.

Originale Beispiele:

Beispiele für motiviertes Denken sind Aussagen wie “Das ist allgemein bekannt” oder “Frag doch irgendwen”. Solche Aussagen zeigen, wie persönliche Überzeugungen die Wahrnehmung und Bewertung von Informationen verzerren können.

Beispiele im KI-Kontext:

- „Jeder weiß, dass KI gefährlich ist“

- „Es ist offensichtlich, dass KI uns überlegen wird“

- Selektive Wahrnehmung von KI-Erfolgen oder -Misserfolgen

8. Echokammer-Denken

Echokammern verstärken vorherrschende Meinungen über KI und schließen andere Perspektiven aus. Dies kann zu einer verzerrten Wahrnehmung der KI-Realität führen.

Originale Beispiele:

Beispiele für Echokammer-Denken sind Aussagen wie “Alle sind meiner Meinung” oder “Jeder weiß das”. Solche Aussagen zeigen, wie Bestätigungssuche die Wahrnehmung und Bewertung von Informationen verzerren kann.

Beispiele im KI-Kontext:

- „Alle Experten sind sich einig über KI“

- „In der Tech-Branche weiß jeder…“

- Mangelnde Diversität in KI-Diskussionen

9. Verwendung des Wortes „falsch“

Absolute Zurückweisungen durch das Wort „falsch“ können die Diskussion und das Verständnis von KI-Implementierungen behindern.

Originale Beispiele:

Beispiele für die Verwendung des Wortes “falsch” sind Aussagen wie “Das ist falsch” oder “Das ist der falsche Ansatz”. Solche Aussagen zeigen, wie absolute Zurückweisungen die Wahrnehmung und Bewertung von Informationen beeinflussen können.

Beispiele im KI-Kontext:

- „Deine Einschätzung zu KI ist völlig falsch“

- „Das ist der falsche Ansatz für KI“

- Kategorische Ablehnung alternativer KI-Ansätze

10. Mangelndes Selbstmitgefühl

Mangelndes Selbstmitgefühl kann zu verstärkter Selbstkritik führen und problematische Glaubenssätze über die eigene Fähigkeit im Umgang mit KI fördern.

Originale Beispiele:

Beispiele für mangelndes Selbstmitgefühl sind Aussagen wie “Ich habe das schlechteste Urteilsvermögen” oder “Ich hätte es wissen müssen”.

Solche Aussagen zeigen, wie übermäßige Selbstkritik die Wahrnehmung und Bewertung der eigenen Fähigkeiten verzerren kann.

Beispiele im KI-Kontext:

- „Ich bin zu dumm für KI“

- „Ich werde nie mit KI umgehen können“

- Selbstlimitierende Überzeugungen

11. Übermäßig großzügige Selbstdarstellung

Übermäßige Selbstdarstellung im KI-Kontext kann zu unrealistischen Erwartungen und Missverständnissen führen.

Originale Beispiele:

Beispiele für übermäßig großzügige Selbstdarstellung sind selektives Teilen von Informationen oder das Überbetonen der eigenen Version. Solche Darstellungen können die Wahrnehmung der eigenen Fähigkeiten und Leistungen verzerren.

Beispiele im KI-Kontext:

- Verschweigung von KI-Fehlern

- Übertriebene Erfolgsgeschichten

- Selektive Präsentation von KI-Ergebnissen

12. Verletzung der Mertonischen Norm des Kommunismus

Die Mertonische Norm des Kommunismus fordert das öffentliche Teilen wissenschaftlicher Ergebnisse und Methoden. Ihre Verletzung behindert den Fortschritt in der KI-Entwicklung.

Originale Beispiele:

Beispiele für die Verletzung der Norm des Kommunismus sind, wenn Forschungsergebnisse nicht in offenen Datenbanken veröffentlicht werden. Solche Praktiken können den wissenschaftlichen Austausch und die Innovation erheblich behindern.

Beispiele im KI-Kontext:

- Voreingenommene KI-Evaluierungen

- Manipulative Darstellung von KI-Outcomes

- Mangelnde Transparenz bei KI-Entwicklungen

13. Entmutigende Ausdrücke

Entmutigende Ausdrücke können das Verständnis und die Diskussion über KI erheblich behindern und Frustration fördern.

Originale Beispiele:

Beispiele für entmutigende Ausdrücke sind Aussagen der Gewissheit oder abwertende Formulierungen wie “Das ist zu komplex für dich”.

Solche Aussagen können das Verständnis und die Diskussion über KI erheblich behindern.

Beispiele im KI-Kontext:

- „Du verstehst KI einfach nicht“

- „Lass das die KI-Experten entscheiden“

- Ausgrenzende Kommunikation

Wenn Sie solche Wörter hören, bitte aufpassen! Besser wäre es verschiedenen Perspektiven einzunehmen.

Annie Dukes Ansatz übertragen auf KI-Implementierung

1. Wahrscheinlichkeitsdenken bei KI

Das bedeutet die Abkehr von absoluten Aussagen zugunsten von Wahrscheinlichkeiten:

- Vermeidung von Aussagen wie „Die KI wird perfekt funktionieren“

- Stattdessen: „Mit 80% Wahrscheinlichkeit wird die KI in diesen Anwendungsfällen gute Ergebnisse liefern„

- Systematisches Einplanen von Fehlerfällen und Abweichungen

- Entwicklung realistischer Erwartungen an die KI-Leistung

2. Prozessorientierung bei KI-Projekten

Der Fokus liegt auf dem Prozess statt nur auf Erfolg oder Misserfolg:

- Bewertung des gesamten Implementierungsprozesses, nicht nur der Endergebnisse

- Extraktion wertvoller Erkenntnisse auch aus „gescheiterten“ KI-Projekten

- Systematische Evaluation aller Entscheidungen im Projektverlauf

- Sorgfältige Dokumentation von Entscheidungsgründen und -prozessen

3. Konfidenzintervalle in der KI-Praxis

Arbeiten mit realistischen Bandbreiten statt Punktschätzungen:

- Definition von Bandbreiten für Projektdauer und Kosten

- Leistungskennzahlen als Bereiche (z.B. „Accuracy zwischen 85-92%„)

- Ressourcenplanung mit Minimum- und Maximumszenarien

- Kontinuierliche Überprüfung und Anpassung der Schätzungen

4. Aktive Fehlersuche

Proaktives Identifizieren von Schwachstellen:

- Systematische Suche nach Schwachstellen im KI-System

- Umfangreiches Testen von Edge Cases und Grenzsituationen

- Integration externer Audits und Überprüfungen

- Aufbau einer systematischen Schwachstellenanalyse

5. Prämortem für KI-Projekte

Vorausschauende Risikoanalyse:

- Antizipation möglicher Fehlschläge bei der KI-Implementierung

- Entwicklung und Durchspielen verschiedener Risikoszenarien

- Erstellung konkreter Notfallpläne

- Definition klarer Frühwarnsignale

6. Systematisches Lernen

Aufbau einer lernenden Organisation:

- Detaillierte Dokumentation der KI-Performanz

- Kontinuierlicher Vergleich zwischen Erwartungen und Realität

- Durchführung von Lessons Learned nach jeder Projektphase

- Entwicklung einer organisationalen Wissensbasis

7. Verzerrungen bei KI-Entscheidungen

Erkennen und Vermeiden kognitiver Verzerrungen:

- Übertriebener Optimismus („KI löst alle Probleme“)

- Unterschätzung der Implementierungskomplexität

- Overconfidence nach ersten Erfolgen

- „Sunk Cost Fallacy“ bei problematischen Projekten

Praktische Umsetzung

Kernelemente der Implementierung

- Entwicklung realistischer Roadmaps mit Unsicherheitsbereichen

- Regelmäßige Überprüfung grundlegender Annahmen

- Transparente Kommunikation aller Unsicherheiten

- Iterative Implementierung mit kontinuierlichen Feedback-Schleifen

- Etablierung eines systematischen Risikomanagements

Kritische Fragen für jedes KI-Projekt

- Worin bestehen die größten Unsicherheiten?

- Welche Annahmen könnten sich als falsch erweisen?

- Was sind realistische Best/Worst-Case Szenarien?

- Wie können wir systematisch aus Fehlern lernen?

Vorteile dieser Denkweise

Die Anwendung von Annie Dukes Ansatz führt zu:

- Realistischerer Projektplanung

- Verbessertem Risikomanagement

- Erhöhter Erfolgswahrscheinlichkeit

- Nachhaltigerem Lernen aus Erfahrungen

- Entwicklung einer gesunden Fehlerkultur

Diese strukturierte Herangehensweise ermöglicht es Organisationen, KI-Projekte mit einem ausgewogenen Verhältnis von Optimismus und Realismus anzugehen. Sie fördert sowohl Innovation als auch Risikobewusstsein und schafft die Grundlage für nachhaltige KI-Implementierungen.

Technische und organisatorische Herausforderungen

Kulturelle und organisatorische Faktoren

- Interne kulturelle Barrieren können das Innovationspotenzial mindern

- Homogenes Denken kann wichtige Perspektiven übersehen

- Mangelnde Selbstakzeptanz kann die Lernbereitschaft behindern

- Pauschale Abwertungen können das Vertrauen in KI-Technologien schädigen

Technologische Faktoren und Datenmanagement

Datenqualität und -verfügbarkeit:

- Hochwertigkeit der Daten ist entscheidend für das Training von KI-Systemen

- Daten müssen relevant, aktuell und korrekt sein

- Kontinuierlicher Datenfluss ist notwendig für die Systemleistung

Integration und Kompatibilität:

- Berücksichtigung diverser technischer Standards

- Herausforderungen bei der Datenspeicherung und -kennzeichnung

- Komplexität der Systemintegration

Sicherheitsaspekte

Sicherheitslücken erkennen:

- Analyse potenzieller Bedrohungen

- Entwicklung umfassender Schutzmaßnahmen

- Regelmäßige Sicherheitsüberprüfungen

Datenschutz und ethische Fragen:

- Einhaltung gesetzlicher Vorgaben

- Schutz der Privatsphäre

- Berücksichtigung digitaler Ethik

Erfolgreiche Implementierungsstrategien

Schrittweise Implementierung

- Ermöglicht Anpassungen und Erkenntnisgewinnung

- Reduziert Risiken

- Steigert die Akzeptanz im Unternehmen

Schulung und Weiterbildung

- Vermittlung von tiefem Verständnis der KI-Technologie

- Förderung der Akzeptanz

- Entwicklung effektiver Nutzungskompetenzen

Zusammenarbeit und Kommunikation

- Vermeidung von Missverständnissen

- Strukturierte Informationsvermittlung

- Förderung der teamübergreifenden Kooperation

Fazit

Die erfolgreiche Implementierung von KI erfordert das Erkennen und Verstehen von Warnsignalen sowie die Entwicklung effektiver Gegenstrategien. Durch die Kombination von technischem Wissen, organisatorischer Kompetenz und kultureller Sensibilität können Unternehmen die Vorteile der KI nutzen und gleichzeitig Risiken minimieren.

Häufig gestellte Fragen

Warum ist die Illusion der Gewissheit gefährlich in der KI-Implementierung?

Die Illusion der Gewissheit führt zu falschen Annahmen über die Leistungsfähigkeit von KI und resultiert in suboptimalen Entscheidungen und erhöhten Risiken.

Wie kann übermäßige Selbstsicherheit die KI-Implementierung beeinträchtigen?

Übermäßige Selbstsicherheit führt dazu, dass wichtige Anpassungen und Risiken ignoriert werden, was zu gravierenden Fehlern und ineffizienten Ergebnissen führen kann.

Was sind Beispiele für irrationale Ergebnisinterpretation in der KI?

Ein typisches Beispiel ist die Behauptung „die KI funktioniert nur bei mir nicht“, was die realen Ursachen für abweichende Ergebnisse ignoriert und das Vertrauen in die Technologie schädigt.

Warum ist die Datenqualität entscheidend für den Erfolg von KI-Projekten?

Hochwertige Daten sind die Grundlage für präzise Analysemuster und effektive Lernprozesse. Schlechte Daten führen zu Fehlinformationen und ineffizienten Ergebnissen.

Wie können Unternehmen die Sicherheitsaspekte bei der KI-Implementierung managen?

Unternehmen sollten potenzielle Bedrohungen analysieren, umfassende Schutzmaßnahmen entwickeln und regelmäßige Sicherheitsüberprüfungen durchführen. Zudem müssen ethische und Datenschutzfragen sorgfältig berücksichtigt werden.